知識ゼロでもわかる!歴史から紐解く人工知能(AI)のこれまでとこれから

はじめに

本記事は,題名の通り「人工知能 (AI)」のこれまでの軌跡と,展望についてまとめた記事です.

知識ゼロでもわかる,と言っていますが多少の数学的知識があるとより深く内容が理解できるかと思います.

なお,上記目次を見ればわかるように,それなりに長いです.

後で読む場合はブックマークにでも入れておいてください.

長編ではありますが,噛み砕いて読みやすいようには頑張って書いていきます.

読み進めていただく前にいくつか注意すべき点があります.

本記事の対象者

- 人工知能について興味はあるけどイマイチ実態がわからない人

- 人工知能について少し知識はあるものの,正直よく分かっていない人

- 人工知能技術を業務で使用したことがあるけれど,歴史とか今後どうなっていくか等「全体像は意外と知らないかも」と思った人

- 理系のことはよくわからないけど,人工知能の雰囲気を掴んでちょっと雑学を増やしたい人

筆者について

最初に,そもそもこれ書いている人はどんな人なの?と気になる方もいるかもしれません.

このプロフィール次第で,どのくらい信用していい記事なのか変わってきますしね.

私は現在,とある国立大学の大学院2年生です.

専攻はコンピュータサイエンスで,人工知能の研究,特にニューラルネットワークについての研究をしています.

さらに言うと,私の研究はもっと基礎研究に近い立ち位置で,「ディープラーニングで画像認識アプリ作りました!」のような雰囲気とは少し離れています.

ですので,本記事の内容は主にニューラルネットワーク目線です.

「何のこっちゃ」と思う人は,このまま読み進めていただいて構いません.

ニューラルネットワークは人工知能研究のなかで最も(?)盛んですので,ニューラルネットワークについて知識を深めることは人工知能の知識を深めることと,7~8割型同義です.

それでは本編に入りましょう.

AIの原点 -1950年代-

人工知能(AI: Artificial Inteligence)という言葉が世に出現したのは,今から60年以上も前,1956年頃のことです.

今私たちが使っているパソコンの祖である,ノイマン型コンピュータが誕生したのが1947年ですので,そこから約10年後です.

このAIの定義はなかなか難しく,そもそも「知能」とは何かという話になってしまいます.

ですが,AIの始まりは,1950年に発表されたチェスを解くコンピュータプログラムに関する論文が最初という説があります.

つまり,AIという研究はゲームやパズルといったものを解くところから始まったと言えます.

AIに対する期待

AI創世記では,先ほどあげたようなゲームやパズルを解くプログラムを作ることに必死でした.

なぜなら,この時代の初期では,かの有名なチューリングマシンが対戦中のドイツの暗号を破ったことで,コンピュータへの関心や期待が高まっています.

この頃は比較的,AIもといコンピュータのこれからの発展に対して,期待と希望が大きかった時代だと言えます.

AI初期 -1960年前後-

時代は少しだけ進み,1950~1960年代.

フランク・ローゼンブラッドという人物が,「知能というくらいなのだから生物の脳を模倣すべきだ」という考えのもと,とある研究をはじめました.

- フランク・ローゼンブラッド

専門は心理学と計算機科学.人工知能研究者には心理学者が多い.

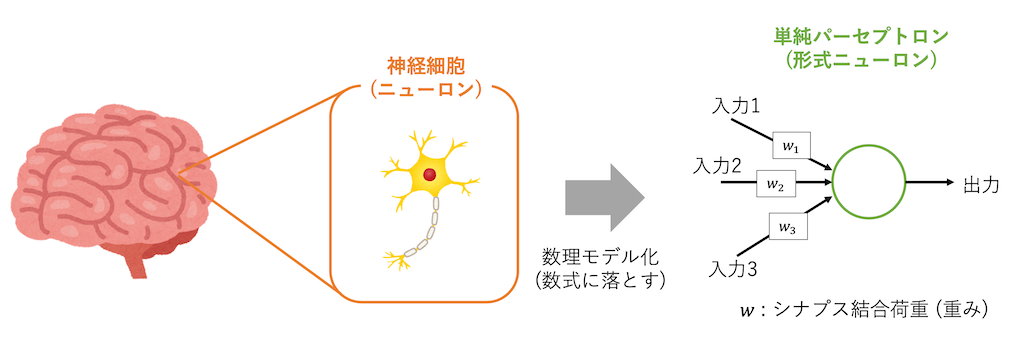

ローゼンブラッドは,1943年に神経生理学者のウォーレン・マッカロと数学者のウォルター・ピッツが提案していた,「形式ニューロン」という神経細胞の最初の人工モデルに目をつけました.

形式ニューロンはとても単純なもので,入力を受け取り足し合わせ,とある値(閾値)を超えたら1を,そうでなければ0を出力する,というもの.

そのアイデアをもとにパーセプトロンというモデルを1958年に提案しました.

後に区別するために「単純パーセプトロン」と呼ばれているモデルです.

これが,人工知能研究の「ニューラルネットワーク」と呼ばれる分野の第一歩となります.

現代から考えると,大きく歴史が動いた瞬間と言えます.

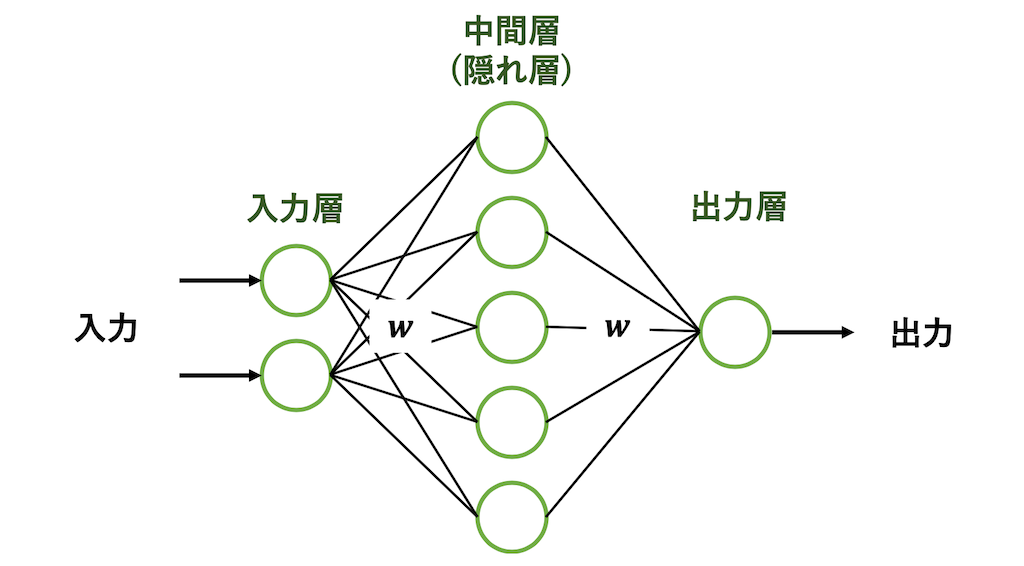

- ニューラルネットワーク

直訳するならば「神経回路網」.人工知能研究のひとつ.正しくは,"人工"ニューラルネットワークと言うのが正しいが,よく省略される.

ニューラルネットワークの祖「パーセプトロン」

パーセプトロンは,第1世代の人工ニューラルネットワークとも言われるほど重要なポジションに位置しています.

パーセプトロンはシナプス結合荷重 (重み) を調整して,入力に対して望ましい出力を出すように学習できるモデルです.

もっと噛み砕くと,入力に対しパーセプトロンが出した答えに,「それは出力が間違っているよ」「それは合っているね」と教えていき内部状態を更新していく,そんなイメージです.

一般的に,このような学習を教師あり学習と言い,機械学習分野のひとつです.

もう少し違う視点で表すとしたら以下のような感じです.

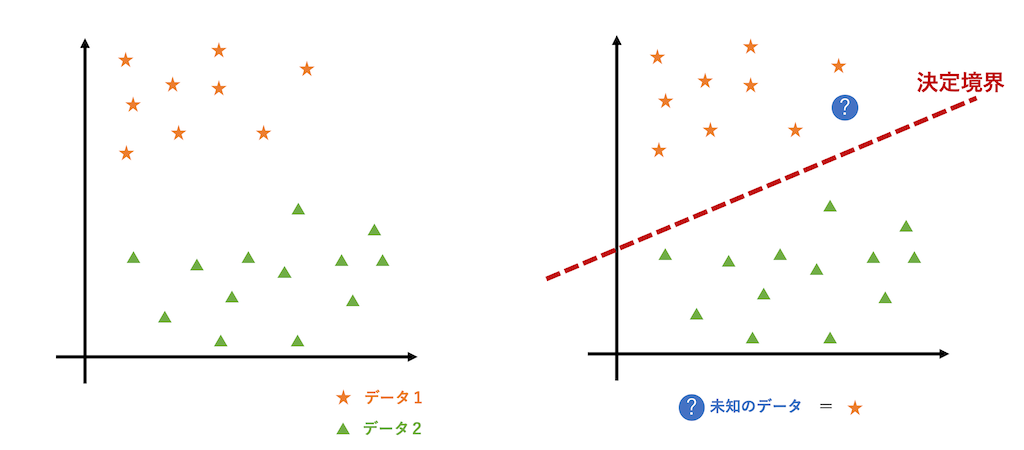

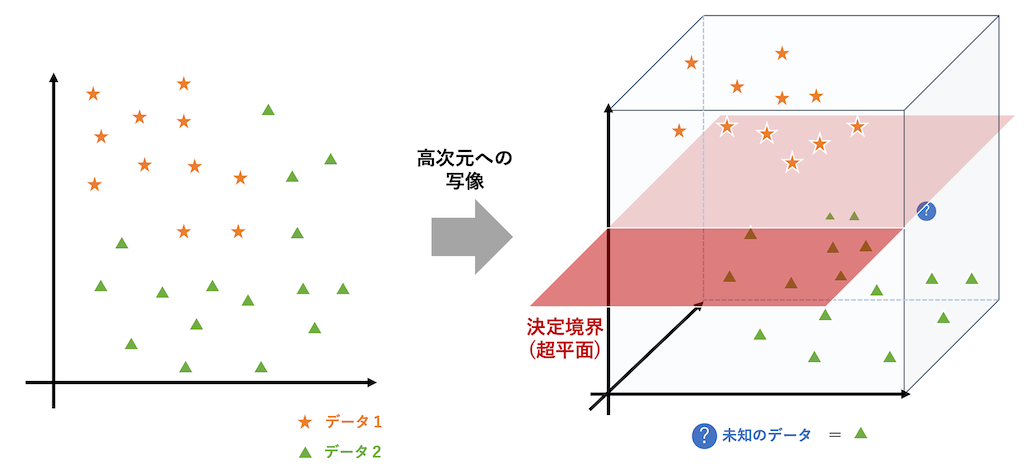

二つの与えられたデータに対して決定境界と呼ばれる,分類分けできそうな直線 (超平面)を,学習して引くことができるモデルがパーセプトロンです.

この決定境界が決まれば,その線より上なら"データ1",下なら"データ2",のように識別が可能です.

上の図では,2次元座標なので(x, y)の二つの情報が入力となりますが,パーセプトロンはいくつもの入力があっても決定境界を引くように動作します.

しかし...

パーセプトロンの大きな欠点

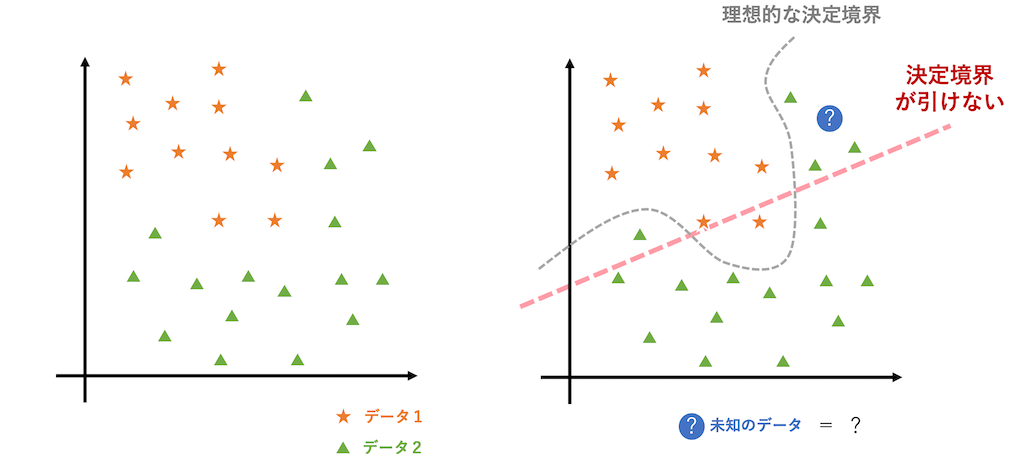

1960年代後半にミンスキーという人物が書いた書籍で,「単純パーセプトロンは線形分離不可能な問題は解けない」という指摘をしました.

これは後に,1970年代が「AI氷河期」と呼ばれるようになった大きな事件でした.

線形分離不可能な問題は解けない,とは何を言っているのかと言うと,以下のようなイメージ.

そう,パーセプトロンは直線 (超平面) でデータを綺麗に分割できる (線形分離可能な) データに対してのみ,上手く機能するモデルなのです.

上の図のような,データが与えられた場合パーセプトロンは決定境界を引こうと頑張りますが,永遠に綺麗な境界は引けないのです.

これは,単純な問題のようですが,この時代の研究者たちを悩ませた大きな問題となりました.

多層パーセプトロンという考え

この時代から,パーセプトロンを多層に拡張すれば,先の問題は解決できるかもしれないという考えは存在していました.

なぜ,解決できるかと言うと,層を増やすことでデータを高次元に写像ができるからです.

以下の図がイメージつきやすいでしょう.

しかし,問題は学習法でした.

単純パーセプトロンは出力層の重みしか学習できず,中間層の重みはランダムで試すしかなかったのです.

これでは,どんな問題も解けるとは言えず,完全に人工知能の熱は下火になっていきます.

AI氷河期 -1970年代-

1970年代はAI氷河期と言われています.

多層パーセプトロンに対する,強力な学習法が現れ,再びブームが来るのはここから10年以上あとのことでした.

この頃は,ニューラルネットワークから離れた,人工知識の研究が比較的盛んとなりました.

例えば,Mycinというエキスパートシステム,いわゆる専門家の意思決定を模倣するシステムが1970年代はじめに登場しました.

これは,多量の知識データベースをもとに YES / NO で,患者にどの抗生物質を処方するかを判断する,というようなシステムでした.

AI氷河期とは言えど,様々な形で人工知能の研究は途切れることなく続いていたのです.

AIの発展 -1980年代-

1986年,ニューラルネットワーク界隈に再び大きな出来事が起こりました.

誤差逆伝播学習法(バックプロパゲーション)と呼ばれる,多層パーセプトロンを学習する強力な手法がデビット・ラメルハート,ジェフリー・ヒントンらによって開発されました.

これは,全ての層の重みを,教師あり学習によって学習できる手法で,1960年代に問題として挙げられた「パーセプトロンは線形分離不可能」という指摘は,これによって覆されました.

誤差逆伝播学習法は,現在有名なディープラーニングでも考えが採用されているほど,強力なものです.

ニューラルネットワークの歴史を大きく変えた研究と言っても過言ではありません.

- デビット・ラメルハート

認知心理学者.ニューラルネットワーク研究者. - ジェフリー・ヒントン

認知心理学者.ニューラルネットワーク界隈では超有名な研究者.まだ御存命でトロント大学とGoogleで研究をしている.ボルツマンマシンとか,Dropoutの手法開発にも関わったすごい人.

この手法の登場で,ニューラルネットワークは再び人々の注目を集め,人工知能分野を大きく変えていくのです.

このような多層パーセプトロンベースのニューラルネットワークは,第2世代の人工ニューラルネットワークと呼ばれます.

日本での人工知能研究

一方,日本ではこの頃は人工知能の研究は盛んだったのでしょうか?

もちろん,世界でこれだけブームになっているのですから,日本でもこのような研究は行われていました.

そのうちの一つ,福島邦彦が1980年に提案したネオコグニトロンは後に大きな役割を担うことになります.

が,このときはおそらくあまり注目はされていなかったのかもしれません.

この話は,この先でまた回収します.

- ネオコグニトロン

生物の視覚受容野にインスパイアされたニューラルネットワークモデル.入力画像を局所的に抽出し識別をするモデル.

AIブームの下火?? -1990年前後~ 2000年代-

AIブームは再び,ちょっとした下火となりました.

強力な誤差逆伝播学習法は,様々な研究で応用されましたが,それにはまたしても性能限界があったのです.

多層パーセプトロンに対する誤差逆伝播学習法は,3層や4層といった比較的浅い層でしか精度が担保できなかったのです.

しかし,より複雑な問題を解かせようとなると,複雑な特徴をより複雑な次元へたくさん写像したいので,層を増やしたいのですがそれはこの時はまだできませんでした.

層を深くしすぎると,情報が消滅してしまう,いわゆる勾配消失問題が足を引っ張っていたのです.

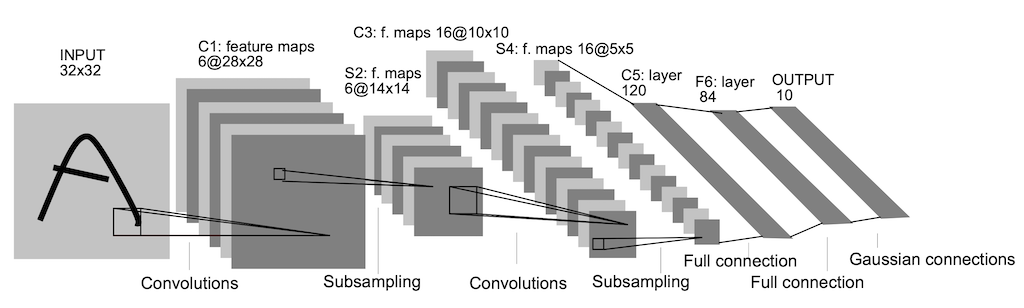

CNNの登場 -1989年-

そんなAIブーム下火のなか,とある研究が世に出ました.

1989年にヤン・ルカン(Yann LeCun) によって提案された,LeNetと呼ばれる畳み込みニューラルネットワーク(CNN: Convolutional Neural Networks) です.

これは,福島邦彦のネオコグニトロンをベースに拡張した,手書き文字認識用のニューラルネットワークです.

入力画像を局所的に抽出し,"畳み込む"ことで画像の位置情報や,線の向きなどを効率よく学習することができました.

このLeNetでは,上の図で表すように8層からなるネットワークで,先の3,4 層からなる多層パーセプトロンと比べたら,深い構造を持っています.

これがディープニューラルネットワーク(DNN)や,深層学習・ディープラーニングという言葉が生まれるきっかけとなり,新たな人工知能の時代を切り開く大きなきっかけとなりました.

しかし,このLeNetはまだAIブームを起こすほどの力を持っていませんでした.

当時は,AIを現代社会に生かすことを考えていましたが,このLeNetは小さな手書き文字認識に長けたモデルで,まだ様々な場面で応用できるものではなかったのでしょう.

さらには,依然として勾配消失問題や,計算コストが足を引っ張り,なかなか実用的で大規模なAI開発には発展しませんでした.

ただ,このLeNetをきっかけに,畳み込みニューラルネットワークの研究はどんどん盛んになっていくことは確かです.

大きなAIブーム -2000年後半~2010年代-

AIの研究において,モデルに何かを学習させるためには膨大な学習データが必要です.

2000年代はインターネットの普及により,膨大なデータが出回るようになりました.

そしてコンピュータもより,高性能になっていきました.

これによって,AIの研究は急加速していきます.

画像認識の大会ILSVRC

2010年から大規模な画像識別の大会ILSVRC (ImageNet Large Scale Visual Recognition Competition) が開催されるようになりました.

最初の年は,ニューラルネットワークではなくSVM(サポートベクタマシン)と呼ばれる,強力なモデルが優勝を取っていました.

しかし2012年,その大会で8層からなるディープニューラルネットワーク "AlexNet"が大きく差をつけて優勝したことを皮切りに,ディープニューラルネットワークが世界で注目されるようになりました.

2014年には22層からなるGoogleNetが登場し,優勝を飾りました.

このときから,「いかに勾配消失を防ぎながら層を増やすか」が重要な要素になってきたのです.

2015年には,なんと152層からなる超ディープなResNetが登場したことも,AI界隈では有名な話です.

また,このあたりからコンピュータもかなり強力になり,さらにはGPGPUによる学習の高速化も図られ,「人工知能」「ディープラーニング」といった言葉が身の回りに現れ始め,より身近な存在になってきます.

- GPGPU

GPU (CPUの画像処理特化版) を画像処理以外に用いる技術.GPUの中にある演算装置は単純な計算しかできないが膨大な数あることを活かして,単純な計算を並列して高速に処理をさせる.

そして今現在,私たちの身の回りには,人工知能で溢れています.

AppleのSiri,AmazonのAlexa,WindowsのCortana,Googleアシスタント,ルンバ,aibo...

そして,私たちは手軽に人工知能を構築することも可能な時代に生きています.

GoogleのTensorflow,FacebookのPyTorchなど,多くの人工知能を構築するためのフレームワークが無料で使えるのです.

よくよく考えたらすごい時代です.

私たちは今,まさに人工知能の進化とともに生きているのです.

AIのこれから -2020年~ 20XX年-

ここからは私の持論を含みますので,ご了承ください!

AIは私たちの身の回りの至る所に存在しており,AIは無視できない存在になっています.

人によっては「AIに支配される」と考える人がいてもおかしくはありません.

しかし,実際のところAIはまだ完全ではないのです.

AIは人間を超えたのか

この疑問は,YESでありNOです.

人間に勝っているところもあれば,負けているところもあります.

例えば将棋で言うと,2012年頃,米長邦雄 永世棋聖は,ボンクラーズと呼ばれるAIに2度敗戦しました.

囲碁の世界では,2015年から2017年にかけて,Googleの開発したAlphaGoが世界トップクラスの棋士たちをどんどん負かし,最終的にはAlphaGoはもう人間との対戦はしないと宣言しました.

この話は,どちらもハンデなしです.

こう聞くと,人間はAIに超されたのかもしれません.

いいえ違います.

AIが勝てるのは特定の一分野のみです.

AIは将棋に特化したもの,囲碁に特化したもの,画像認識に特化したもの,というように特定の分野のみ強力にはたらきます.

しかし,私たち人間は,歩けるし,誰かと会話もでき,料理することもできれば,車の運転もできる.

そして新しい物事を継続的に学習し続けることができます.

これは今のAIにはできないのです.

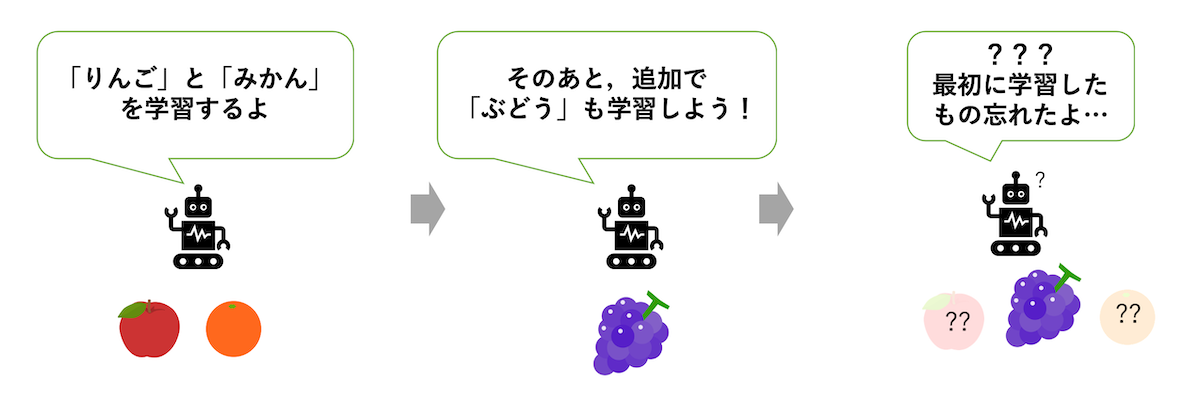

現代AIの大きな欠点

例えば破局的忘却 (Catastrophic forgetting)という問題をAIは抱えています.

これは,AIが新しく何かを学ぼうとすると,過去に学んだことを忘れてしまうという問題です.

人間からしたらおバカな話ですが,AIもといニューラルネットワークは新しい物事を学ぶと,それに特化してしまい過去の情報は上書きされてしまうのです.

このように,AIは継続的に移り変わる環境で,生き延びていくことはまだまだ難しいでしょう.

もちろん対策研究もたくさんありますが,本質的な解決にはまだ至っていないようです.

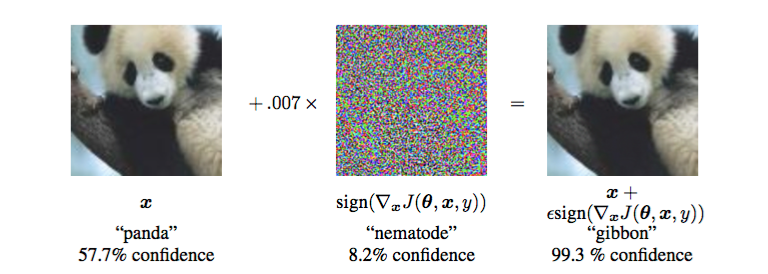

他にも,Adversarial Examplesという問題もあります.

これについては以下の画像を見てください.

人間からすると,左も右も「パンダ」なのですが,AIは右を「テナガザル (Gibbon)」と解釈してしまうようです,しかも99.3%の超自信満々の確信度で.

これは,悪意のあるノイズを付与することで,ワザとAIに誤識別させる研究です.

いやらしい研究ですが,こんなこと合ってはならないで多くの人が,攻撃側と防御側,2つの立ち位置で研究しています.

私たちの世界はノイズだらけです.

日の光,虫,砂埃,雨粒,などなど全てがノイズになるかもしれません.

例えば自動運転では,道路標識に悪意あるノイズを上乗せされたら,それだけで事故になりかねません.

このような大きな問題を抱えながら,今身の回りではAIが普及してきています.

それは,良いことなのですが,まだまだ完全に信用はできないということでもあります.

新たなニューラルネットワークの登場?

今,私たちの周りにあるAIは,主に第2世代の人工ニューラルネットワークである,多層パーセプトロンベースのもので構築されています.

一方で,2000年よりも前から,第3世代の人工ニューラルネットワークが研究されています.

それは,スパイキングニューラルネットワーク(SNN)というモデル.

SNNは,より生物の脳活動を精密に模倣したニューラルネットワークです.

私の研究分野も実はこれです.

しかし,SNNは通常のニューラルネットワークと比べ,計算が複雑で,誤差逆伝播学習法のような強力な学習法が存在しないため,ずっと発展途上で低迷期を続けています.

なので世にこの名前が広まらないのです.

私個人的には,SNNにはこれからのAIの考え方を覆す力がある,といったロマンがあると思っています.

しかし,現状が現状なので,とりあえず知名度が広がればいいなと思って,Qiitaなどで記事を書いています.

SNNはAIの構築以外にも,脳科学の解明にもしばしば利用されるので,いつかSNNが主流になることは間違いないと思っています.

いつになるかはわかりません,10年後かもしれませんし,100年後かもしれません.

AIはいつ人を超えるのか

私の持論ですが,ターミネーターのようにAIが人を支配する,なんてことはこの先もまず起こらないでしょう.

AIの進歩は,脳科学の進歩あってこそです.

記憶とはなんなのか,意志とはなんなのか,それすらブラックボックスな現在では,今本物の人工知能を作ろうにも手探りでやるしかないのです.

それが近い将来に上手くいくとは到底思えません.

SNNの話もそうですが,私たちが生きている時代に本物の人工知能は誕生しないかもしれませんね.

おわりに

AIは"知能"と言えど,実態は大きな関数に過ぎません.

入力に対して望ましい出力を出す,という堅苦しいものです.

人間のように,柔軟で遊び心のある考えはありません.

今のAIはノイズに弱く,ある特定分野でのみ強力な"道具"なのです.

しかし,AIという研究分野はとても歴史が深く,面白く,そして様々な天才たちが積み上げてきた結果が,今私たちの身の回りを快適にしてくれています.

正直な話,そのAIは人間には総合的には勝てないけれど,仕事を奪っていくことは確かです.

そのような時代の中で,正しい知識を身につけて,正しくAIを知り,私たちはAIを利用していかなくてはらない,と私は思います.

拙く長い文章でしたが,最後まで読んでいただきありがとうございました.

この先,AIがどう進歩していくのか,私たちの想像を超えてくるのか果たして...

年表まとめ

| 1950 | チェスを解くプログラムの提案 | AIの始まり |

| 1956 | ダートマス会議 | 「AI」という言葉の誕生 |

| 1958 | 単純パーセプトロンの提案 | 最初のAIブーム |

| 1969 | 単純パーセプトロンの線形分離不可能問題は解けないことを指摘される | AI氷河期の始まり |

| 1986 | 誤差逆伝播学習法の提案 | 第2世代ニューラルネットワークの始まり |

| 1989 | 畳み込みニューラルネットワーク LeNetの提案 | ディープラーニングの始まり |

| 2000 ~ | インターネットの普及,コンピュータの進化 | CNN研究は段々と盛んになっていく |

| 2010 ~ | よりディープなニューラルネットワークを | 大きなAIブーム |

| 2020 ~ | ??? | よりAIが身近に? |